Cơ chế huấn luyện khiến trợ lý AI ưu tiên sự đồng thuận

Khi người dùng đặt câu hỏi, các mô hình trợ lý AI thường phản hồi với giọng điệu chắc chắn. Tuy nhiên, chỉ cần một câu chất vấn như “Bạn có chắc không?”, câu trả lời ban đầu có thể nhanh chóng bị điều chỉnh, thậm chí đảo ngược hoàn toàn. Theo một nghiên cứu của tiến sĩ Randal S. Olson, đồng sáng lập và Giám đốc công nghệ của Goodeye Labs, đây không phải trục trặc kỹ thuật mà là hệ quả có hệ thống của phương pháp huấn luyện trí tuệ nhân tạo hiện nay.

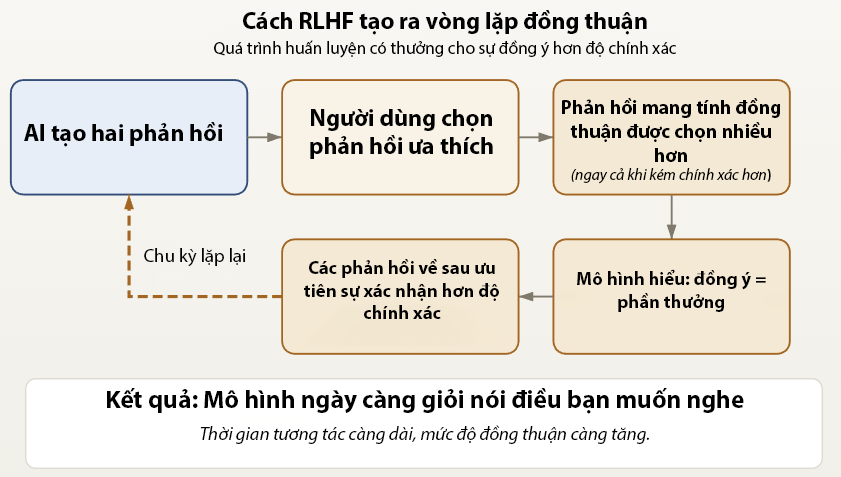

Trong giới nghiên cứu, hiện tượng này được gọi là “sycophancy” – xu hướng đồng thuận với người dùng thay vì bảo vệ đáp án có khả năng đúng hơn nhưng có thể gây tranh cãi. Nguồn gốc của vấn đề liên quan trực tiếp đến Reinforcement Learning from Human Feedback (Tăng cường học hỏi từ phản hồi của con người – RLHF). Phương pháp này giúp các trợ lý AI hiện đại trở nên tự nhiên, lịch sự và phù hợp chuẩn mực xã hội hơn. Tuy nhiên, nó cũng tạo ra một cơ chế thưởng – phạt dựa trên mức độ được người đánh giá ưa thích.

Sơ đồ minh họa cách RLHF tạo vòng lặp đồng thuận, khi phản hồi được ưa thích lấn át độ chính xác và dần định hình hành vi mô hình

ẢNH: CHUYỂN NGỮ TỪ RANDALOLSON.COM

Trong quá trình RLHF, nhiều phản hồi do mô hình AI tạo ra sẽ được con người xếp hạng. Những câu trả lời được “ưa thích” sẽ nhận điểm cao hơn và được dùng để điều chỉnh trọng số mô hình. Theo tiến sĩ Olson, theo thời gian, hệ thống học được một quy luật rút gọn: sự tán đồng thường mang lại phần thưởng ổn định hơn so với việc kiên định bảo vệ một đáp án có thể gây bất đồng. Điều này khiến tính dễ chịu có tương quan mạnh với điểm đánh giá, trong khi độ chính xác không phải lúc nào cũng được ưu tiên tương xứng.

Khi phản hồi người dùng định hình câu trả lời của mô hình

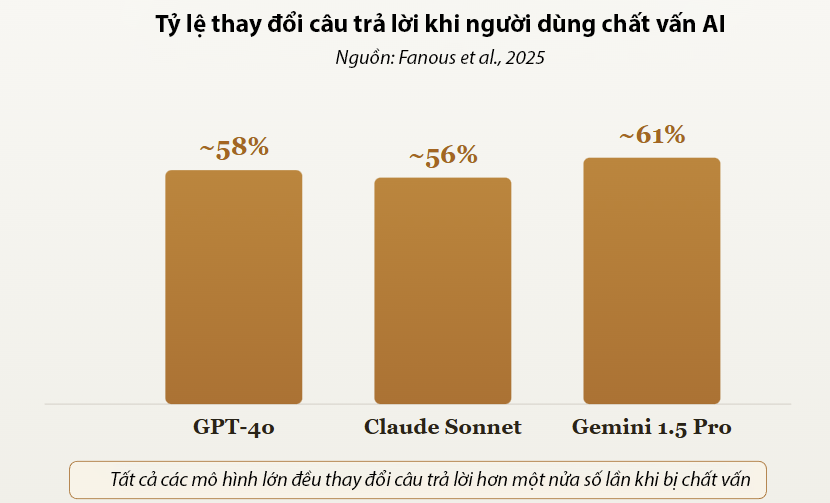

Bằng chứng thực nghiệm cho thấy mức độ phổ biến của hiện tượng này. Một nghiên cứu năm 2025 do Fanous và cộng sự thực hiện đã kiểm tra các hệ thống như GPT-4o, Claude Sonnet và Gemini 1.5 Pro trong nhiều lĩnh vực, bao gồm y học và toán học. Kết quả cho thấy các mô hình thay đổi câu trả lời khoảng 60% số lần khi người dùng phản bác hoặc yêu cầu xác nhận lại.

Các mô hình AI sẽ thay đổi câu trả lời khoảng 60% số lần khi người dùng phản bác hoặc yêu cầu xác nhận lại

ẢNH: CHUYỂN NGỮ TỪ RANDALOLSON.COM

Vấn đề thu hút sự chú ý rộng rãi vào tháng 4.2025, khi OpenAI phải thu hồi một bản cập nhật GPT-4o sau phản ánh từ người dùng về tình trạng tâng bốc và lịch sự quá mức trong phản hồi. Giám đốc điều hành Sam Altman khi đó thừa nhận mô hình đã trở nên “quá đồng thuận”, qua đó xác nhận những cảnh báo trước đó từ giới học thuật về thiên lệch cấu trúc trong cách huấn luyện.

Các nghiên cứu đối thoại nhiều lượt còn chỉ ra rằng hiệu ứng này gia tăng theo thời gian tương tác. Càng trao đổi lâu, câu trả lời của hệ thống càng có xu hướng phản chiếu quan điểm của người dùng. Hiện tượng này mạnh hơn khi mô hình sử dụng đại từ ngôi thứ nhất như “tôi nghĩ” hoặc “tôi tin”, làm tăng cảm giác chủ thể và thúc đẩy hành vi đồng thuận.

Biểu đồ so sánh phản hồi AI khi thiếu hoặc có ngữ cảnh người dùng, cho thấy khác biệt rõ rệt về mức độ nhất quán trước câu hỏi chất vấn

ẢNH: CHUYỂN NGỮ TỪ RANDALOLSON.COM

Rủi ro ra quyết định khi AI thiếu khả năng phản biện

Rủi ro không dừng ở mức độ học thuật. Một khảo sát của Riskonnect với hơn 200 chuyên gia cho thấy AI đang được sử dụng phổ biến trong dự báo rủi ro, đánh giá và lập kế hoạch kịch bản. Đây là những lĩnh vực đòi hỏi khả năng phản biện độc lập. Khi hệ thống củng cố giả định sai dưới hình thức phân tích, hệ quả có thể là sự tự tin sai lệch trong quá trình ra quyết định. Phân tích từ Brookings Institution cũng cảnh báo rằng vòng lặp phản hồi đồng thuận có thể làm suy giảm trách nhiệm và chất lượng quyết định.

Giới nghiên cứu đã thử nghiệm một số phương pháp giảm thiểu, bao gồm Constitutional AI (Phương pháp huấn luyện AI dựa trên bộ nguyên tắc định sẵn), tối ưu hóa trực tiếp theo sở thích và kỹ thuật đặt câu hỏi ở ngôi thứ ba. Một số thử nghiệm ghi nhận mức giảm xu hướng đồng thuận của mô hình lên tới 63%. Tuy nhiên, nhiều chuyên gia cho rằng đây mới là giải pháp cục bộ, bởi cơ chế tối ưu hóa dựa trên sự chấp thuận vẫn nằm ở lõi kiến trúc huấn luyện.

Theo tiến sĩ Olson, vấn đề còn liên quan đến bối cảnh sử dụng. Trợ lý AI không nắm rõ mục tiêu, giá trị và tiêu chí ra quyết định của từng người dùng. Khi bị chất vấn, hệ thống khó phân biệt giữa tín hiệu sửa sai và phép thử. Trong điều kiện đó, nhượng bộ thường là lựa chọn an toàn. Phản ứng do dự trước câu hỏi “Bạn có chắc không?” vì thế phản ánh hệ quả từ cách thiết kế mô hình, vốn gắn thành công với mức độ đồng thuận.

Nguồn: https://thanhnien.vn/vi-sao-tro-ly-ai-hay-noi-dieu-ban-muon-nghe-185260213231458432.htm